Jos teet Google-mainontaa tai SEO-sisältöjä, tai olet muuten vaan kiinnostunut digitaalisen markkinoinnin toimintakentästä, olet takuulla usein puhuttavan Googlen algoritmeistä. Kahvipöytäkeskusteluissa, markkinointipuheissa ja sähköpostiketjuissa termi heitetään tosin monesti ilmoille lähinnä käsitteellisellä tasolla, ikään kuin kyseessä olisi jokin abstrakti organismi, joka mielivaltaisesti päättää, milloin mikäkin sivu ilmestyy käyttäjän Google-haun etusivun kärkeen.

Hakukonealgoritmit ovat kuitenkin lopulta vain suuri määrä koodia, joka erinäisten kriteerien perusteella vertailee ja arvottaa nettisivuja keskenään. Googlen algoritmien tarkoituksena on vain ja ainoastaan näyttää hakukoneen käyttäjille mahdollisimman todenmukaisia, relevantteja ja luotettavia hakutuloksia. SEO-ekspertit (Search Engine Optimization) ja verkostomarkkinoijat taas pyrkivät aina nousemaan hakutuloksissa yhä korkeammalle saadakseen taloudellista hyötyä.

Google ja hakukoneoptimoijat pelaavatkin eräänlaista kissa–hiiri-leikkiä. Leikissä vallitsee kuitenkin aina Googlen pelisäännöt ja siksi teknologiajätti päivittää algoritmiaan usein, jopa satoja kertoja vuodessa. Tässä artikkelissa esittelemme toistaiseksi tärkeimmät muutokset, joita Google on algoritmeihinsä tehnyt.

Panda (2011)

Tähän 9 vuotta sitten julkaistuun algoritmipäivitykseen pohjautuu edelleen valtaosa hakukoneoptimointibisneksessä vallitsevista “yleissäännöistä”: sisällön pitää olla uniikkia, itseään toistava sisältö heikentää tuloksia, hakusanoja ei saa olla liian tiheästi peräkkäin ja niin edelleen. Viimeksi mainitun “keyword stuffingin” Google otti hampaisiinsa jo vuonna 2003, mutta Pandan myötä hakusanojen esiintymistiheyteen ja toistomäärään suhteutettuna sivuston sisältömäärään alettiin kiinnittämään enemmän huomiota.

Panda pakotti monet hakukonetuloksia manipuloivat toimijat muuttamaan strategiaansa täysin ja keskittymään uniikin, hyödyllisen sisällön tuottamiseen pelkkien hakusanojen listaamisen sijasta. Sittemmin Google on jatkokehittänyt keyword stuffingin estämistä muun muassa ottamalla paremmin huomioon sanojen taivutusmuodot eri kielillä. Tämä on edesauttanut niin sanottujen “aitojen sivujen” menestymistä hakutuloksissa hakukoneoptimoitujen sivustojen sijasta.

Penguin (2012)

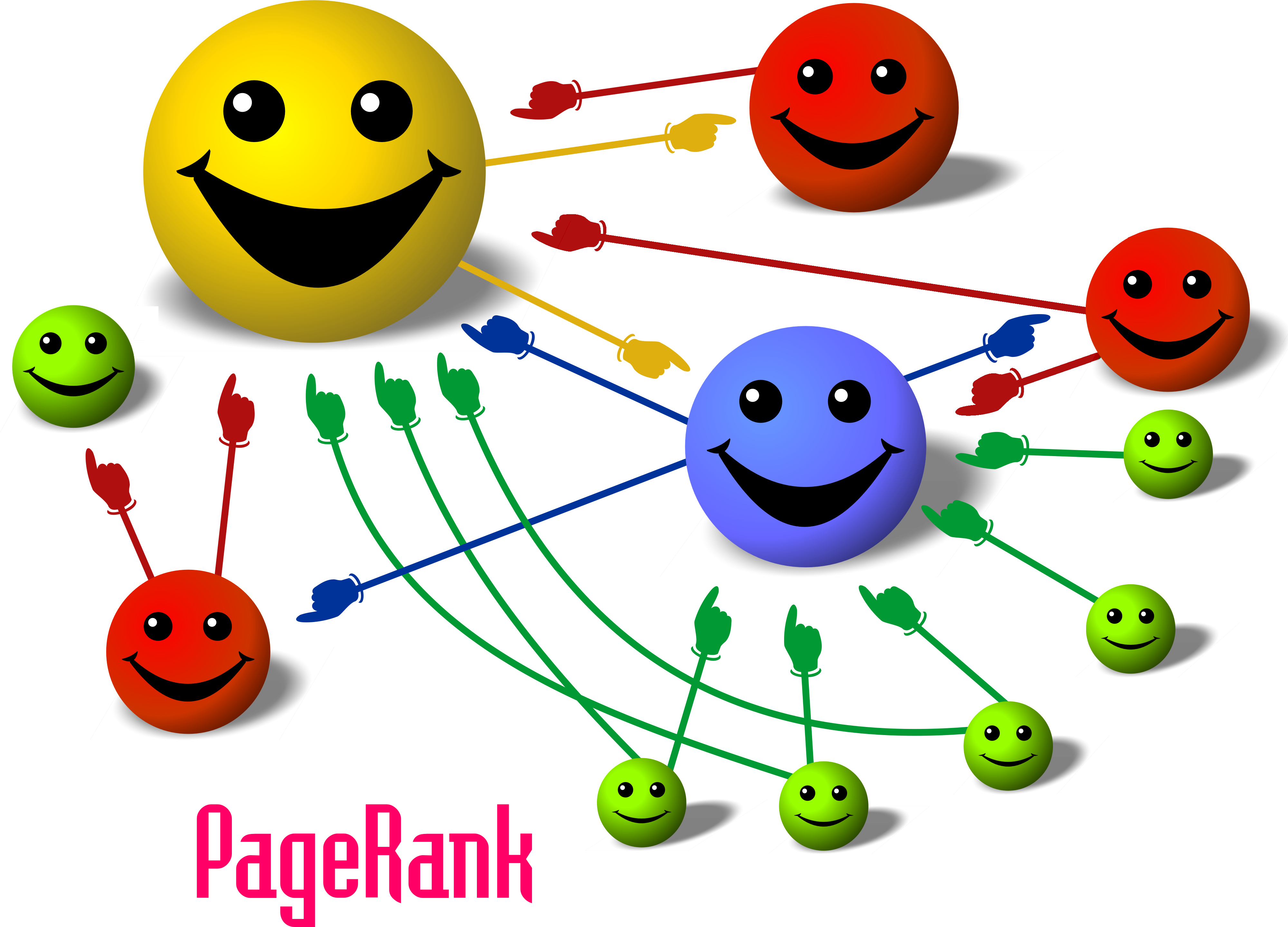

Siinä, missä Panda keskittyi hakusanoihin ja sisältöön, vuotta myöhemmin julkaistu Penguin vaikutti linkkien manipulointiin. Linkit ovat olleet aina tärkeässä osassa Googlen algoritmejä. Linkkien on ajateltu olevan eräänlainen tae luotettavasta sivustosta: jos ulkopuolinen sivusto linkkaa käyttäjän sivulle, sivun täytyy olla luotettava, koska sitä “siteerataan”. Penguin ei tietenkään alkanut rankaisemaan sivustoja linkkien käytöstä – ristiinlinkkaustahan tekevät niin valtion virastot kuin uutissiustotkin – mutta sen sijaan päivityksellä haluttiin tehdä vaikeammaksi hakutuloksissa nouseminen pelkän aggressiivisen linkkisuunnittelun avulla.

Penguin toimii siten, että se laskee sivuston hakutulosarvoa, mikäli se kokee, että sivustolle johtavat linkit on luotu ainoastaan SEO-tarkoituksessa. Jos siis aiemmin pystyi nostamaan sivustoaan tuloksissa ylöspäin omistamalla monta eri verkkotunnusta ja linkkaamalla jokaisesta sivustosta omalle pääsivustolleen, Penguin käytännössä torppasi tämän toiminnan kokonaan.

Mobile (2015)

Saattoi tuntua aluksi oudolta, että Google laskee sivuston arvoa, mikäli se ei ole mobiiliystävällinen, sillä vielä viisi vuotta takaperin kosketusnäytölle automaattisesti skaalautuvan nettisivuston suunnitteleminen ei ollut niin yksinkertaista ja halpaa kuin se on nyt. Syy päivitykseen oli kuitenkin selvä: netin mobiilikäyttö oli yleistynyt huimasti ja jos sivu ei toiminut hyvin puhelimella, siitä ei ollut käyttäjälle hyötyä.

Nykyään maailman suosituimmat verkkosivualustat, kuten Squarespace ja WordPress hyödyntävät responsiivista HTML5-tekniikkaa, mikä tarkoittaa, että niillä rakennetut sivustot tunnistavat laitteen näyttökoon ja skaalautuvat automaattisesti sen mukaan. Nykyään Mobile ei tuotakaan enää juurikaan päänvaivaa verkkosuunnittelijoille ja hakukoneoptimoijille, mutta vielä viisi vuotta sitten aiheutti!

Fred (2017)

Vaikka Fred ei itsessään tuonut mitään uutta algoritmeihin, on se silti yksi merkittävimmistä algoritmipäivityksistä toistaiseksi. Käytännössä Fred jatkoi sitä työtä, minkä Panda ja Penguin aloittivat: puhtaasti taloushyötyä tavoittelevat mainos- ja affiliaattisivut saivat huonot rankkaukset hakutuloksissa. Päivityksen myötä Google käy yhä tarkemmin läpi sivuston kokonaisrakennetta ja linkkien infrastruktuuria – jos tekstiin upotetut linkit ovat aivan irrallaan kontekstista tai johtavat käyttäjää harhaan, vaikuttaa se negatiivisesti hakutulosnäkyvyyteen.

Toisin kuin virheellisesti usein luullaan, verkkotunnuksen, eli domainin ikä ei itsessään vaikuta hakutulosrankingissä nousemiseen, ainoastaan domainin maineella on merkitystä. Siksi vanhojen, suosittujen nettipalveluiden vanhentuneet domainit ovat usein haluttua tavaraa SEO-bisneksessä – ne ovat vuosien ajan generoineet paljon sivukäyntejä ja linkkauksia.